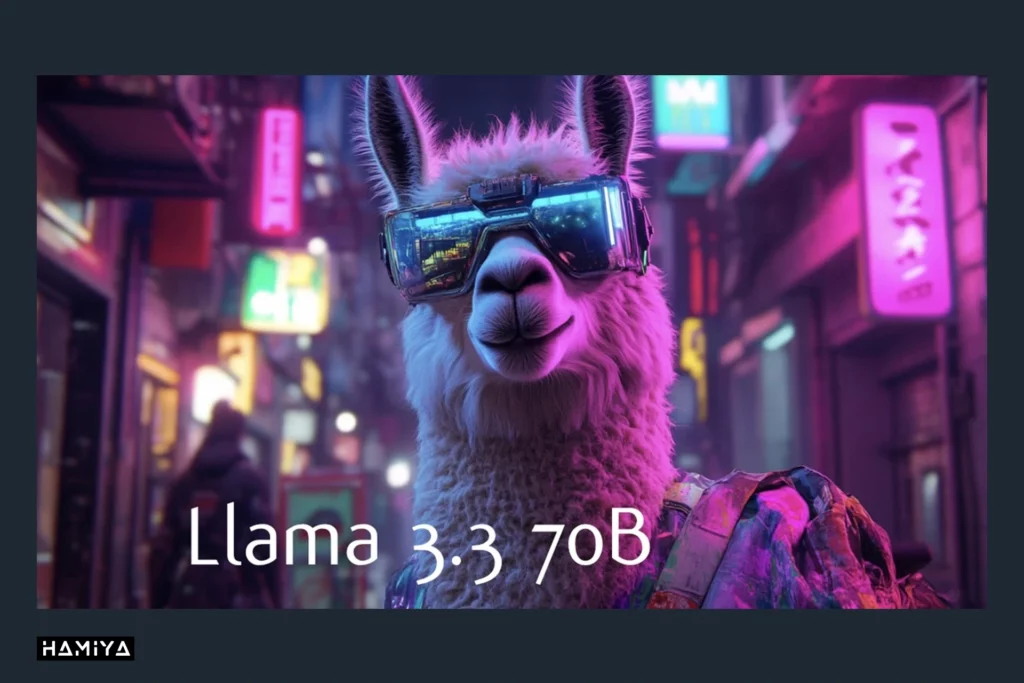

شرکت متا با معرفی مدل زبانی بزرگ Llama 3.3، گام مهمی در جهت توسعه هوش مصنوعی عملی و قابل دسترسی برداشتهاست. این مدل که در تاریخ 6 دسامبر 2024 رونمایی شد، به عنوان یک نسخه بهبود یافته و کارآمدتر از مدل قبلی خود، Llama 3.1، شناخته میشود. مدل Llama 3.3 ضمن حفظ قابلیتهای پیشین، نیاز به منابع محاسباتی عظیم را به طور قابل توجهی کاهش دادهاست. بدین ترتیب، این مدل نه تنها یک ابزار قدرتمند برای متخصصان هوش مصنوعی، بلکه یک گزینه جذاب برای توسعهدهندگان و محققان با منابع محدود نیز به شمار میرود. با مدل Llama 3.3، دیگر نیازی به سختافزارهای تخصصی و انرژی بسیار زیاد نیست؛ بلکه یک سیستم استاندارد و رویکردی صحیح برای کار با این مدل کافی است.

مدل Llama 3.3 با ارائه عملکردی سریع، قابل اعتماد و مقرون به صرفه در طیف وسیعی از وظایف هوش مصنوعی، از دیگر مدلهای مشابه متمایز میشود. علاوه بر سرعت بالا، این مدل از استراتژیهای همترازی جدید و تکنیکهای یادگیری تقویتی آنلاین پیشرفته بهره میبرد که به آن امکان میدهد تا نتایج تولید شده توسط خود را با ترجیحات انسانی بهتر همراستا سازد. در نتیجه، خروجیهای مدل Llama 3.3 به طور قابل توجهی مفیدتر، مسئولانهتر و قویتر شدهاند.

برای کسب اطلاعات بیشتر در مورد مجوز استفاده از مدل Llama 3.3 و بررسی آن در پلتفرم Hugging Face، میتوانید از لینکهای ارائه شده استفاده کنید. این دو منبع به توسعهدهندگان و محققان این امکان را میدهند تا با اکوسیستمی آشنا شوند که در آن ارزشهای منبع باز با قابلیتهای پیشرفته هوش مصنوعی ترکیب شدهاست. دسترسی آزاد به این مدل، فرصتی را برای همه افراد، از توسعهدهندگان مستقل تا شرکتهای بزرگ، فراهم میکند تا از مدلهای زبانی پیشرفته بدون نگرانی در مورد هزینههای گزاف استفاده کنند.

فهرست مطالب

کارایی، قابلیت ها و معماری اصلی در مدل Llama 3.3

مدل زبانی بزرگ Llama 3.3 با هدف رفع یکی از چالشهای اصلی در حوزه هوش مصنوعی طراحی شدهاست: چگونگی ترکیب قابلیتهای مدلهای بسیار بزرگ با هزینههای محاسباتی مقرون به صرفه. توسعهدهندگان اغلب با محدودیتهای ناشی از تعداد پارامترهای عظیم، نیاز به GPUهای قدرتمند، هزینههای بالا و کاهش سرعت توسعه در مدلهای بزرگ مواجه هستند. اما تیم توسعهدهندگان مدل Llama 3.3 در متا با اتخاذ رویکردهای جدید همترازی و تکنیکهای یادگیری تقویتی آنلاین، ضمن کاهش پیچیدگی محاسباتی، به دنبال بهبود عملکرد مدل بودهاند.

نتیجه این تلاشها آن است که اکنون میتوان بسیاری از وظایف پیچیده و تولید دادههای مصنوعی را که پیش از این نیازمند زیرساختهای محاسباتی قدرتمندی بود، با استفاده از سختافزارهای رایج انجام داد. برای مثال، تنظیم دقیق یک دستیار گفتگو چندزبانه که از زبانهای مختلفی همچون انگلیسی، آلمانی، فرانسوی، ایتالیایی، پرتغالی، هندی، اسپانیایی و تایلندی پشتیبانی میکند، دیگر به منابع محاسباتی عظیمی نیاز ندارد. با مدل Llama 3.3، توسعهدهندگان مستقل و کسبوکارهای کوچک نیز میتوانند به این قابلیتها دسترسی پیدا کنند.

معماری مدل Llama 3.3 بر اساس نسخه اصلاحشدهای از مدلهای ترنسفورمر ساخته شدهاست و از رویکرد پیشآموزشی، تنظیم دقیق نظارت شده (SFT) و یادگیری تقویتی با بازخورد انسانی (RLHF) با استفاده از دستورالعملها بهره میبرد. این مدل علاوه بر تسلط بر تولید متن، بر اساس ترجیحات انسانی مانند مفید بودن و ایمنی آموزش دیدهاست. همچنین، مکانیزم توجه پرسوجوی گروهی (GQA) در این مدل برای بهبود مقیاسپذیری استنتاج به کار رفتهاست. با پنجره کانالی 128 هزار توکنی و تعداد کل توکن بیش از 15 تریلیون، مدل Llama 3.3 قادر است ورودیهای بسیار بزرگ را بدون کاهش کارایی پردازش کند. برای درک عمیق مفاهیمی مانند توکن، پنجره کانالی و غیره میتوانید مقاله منتشر در این موضوعات با عنوان “رمزگشایی از دنیای هوش مصنوعی و LLM: از توکنها تا پنجرههای کانالی” از هامیا ژورنال را مطالعه نمایید.

| مشخصه | مقدار | توضیحات |

| دادههای آموزشی | ترکیبی جدیدی از دادههای عمومی آنلاین | مدل بر روی مجموعهای متنوع از دادههای متنی موجود در اینترنت آموزش دیدهاست. |

| پارامترها | 70 میلیارد | تعداد پارامترهای قابل تنظیم در مدل است که نشاندهنده پیچیدگی و توانایی مدل در یادگیری الگوهای پیچیدهاست. |

| مدالیته ورودی | چندزبانه (متن) | مدل میتواند ورودیهای متنی به زبانهای مختلف را پردازش کند. |

| مدالیته خروجی | چندزبانه (متن و کد) | مدل میتواند خروجیهای متنی و کدهای برنامهنویسی به زبانهای مختلف تولید کند. |

| پنجره کانالی | 128 هزار توکن | حداکثر تعداد توکنهایی که مدل میتواند به طور همزمان پردازش کند. توکنها واحدهای کوچکی از متن هستند. |

| مکانیزم GQA | بله | مدل قادر به پاسخگویی به سوالات است. |

| تعداد توکنها | 15 تریلیون+ | تعداد کل توکنهای استفاده شده برای آموزش مدل است. |

| قطع دانش | دسامبر 2023 | مدل بر اساس اطلاعاتی که تا دسامبر 2023 در دسترس بوده آموزش دیدهاست و از آن پس به روزرسانی نشده است. |

مدل Llama 3.3 در ارزیابیهای مختلف عملکرد بسیار خوبی از خود نشان دادهاست. این مدل در وظایف عمومی، استدلال، تولید کد، ریاضی و معیارهای چند زبانه مانند MMLU، GPQA Diamond، HumanEval، MBPP EvalPlus و MGSM با مدلهای قبلی خود برابری کرده یا حتی از آنها پیشی گرفتهاست. به عنوان مثال، Llama 3.3 در وظایف مربوط به تولید کد، نتایج بسیار خوبی کسب کرده و در مقایسه با مدلهایی که منبع باز (Open Source) نیستند، عملکرد بهتری داشتهاست. این مدل در معیار HumanEval امتیاز 88.4 و در معیار MBPP EvalPlus نیز امتیاز 87.6 را کسب کردهاست. همچنین، عملکرد این مدل در حل مسائل ریاضی نیز بهبود یافته و با کسب امتیاز 77 در معیار MATH (CoT) از مدلهای قدیمی پیشی گرفتهاست. این نتایج نشان میدهند که مدل Llama 3.3 نه تنها یک مدل زبانی بزرگ است، بلکه قادر به انجام وظایف پیچیده و متنوع با دقت و کارایی بالا است.

توسعه مسئولانه، ایمنی و ملاحظات زیست محیطی در مدل Llama 3.3

اگرچه کارایی و قابلیتهای یک مدل زبانی بزرگ از اهمیت بالایی برخوردار است، اما توجه به جنبههای دیگری همچون ایمنی، مسئولیتپذیری و تأثیر زیستمحیطی نیز ضروری است. خوشبختانه، شرکت متا در توسعه مدل Llama 3.3 به این موارد به طور جدی پرداختهاست.

یکی از مهمترین جنبههای مورد توجه در توسعه مدل Llama 3.3، ایمنی این مدل است. با آگاهی از خطرات بالقوه تولید محتوای نامناسب توسط مدلهای زبانی بزرگ، متا رویکردی سهجانبه را اتخاذ کردهاست: اول، توانمندسازی توسعهدهندگان برای ایجاد محیطهای ایمن؛ دوم، محافظت از توسعهدهندگان در برابر سوء استفادههای احتمالی؛ و سوم، حفاظت از جامعه در برابر پیامدهای منفی استفاده نادرست از مدل! برای دستیابی به این هدف، متا فرآیند همترازی مدل را بهبود بخشیده و با استفاده از دادههای “تنظیم دقیق ایمن” و تکنیک یادگیری تقویتی با بازخورد انسانی (RLHF)، توانستهاست مدل Llama 3.3 را به گونهای آموزش دهد که از تولید محتوای مضر خودداری کرده و لحنی مفید و احترامآمیز را حفظ کند.

مدل Llama 3.3 به عنوان یک مدل مستقل عمل نمیکند، بلکه بخشی از یک سیستم جامع است که شامل ابزارهای حفاظتی مانند Llama Guard 3، Prompt Guard و Code Shield میباشد. این ابزارها به عنوان لایههای امنیتی عمل کرده و خطرات ایمنی و امنیتی را کاهش میدهند. علاوه بر این، توسعهدهندگان میتوانند سیاستهای مدل را با توجه به نیازهای خاص خود سفارشیسازی کنند. با اتکا به دستورالعملهای استفاده مسئولانه متا، مدل Llama 3.3 محیطی امن و شفاف را برای توسعه و استفاده از مدلهای زبانی بزرگ فراهم میکند.

یکی از دغدغههای اصلی در توسعه مدلهای بزرگ زبانی، تأثیرات زیستمحیطی آنها است. آموزش این مدلها به مقدار قابل توجهی انرژی نیاز دارد. با این حال، شرکت متا با رویکردی شفاف به این موضوع پرداختهاست. بر اساس برآوردهای ارائه شده، برای آموزش مدل Llama 3.3 حدود 7 میلیون ساعت پردازنده گرافیکی (GPU Hours)1 بر روی H100-80 گیگابایتی استفاده شدهاست. هر یک از این پردازندهها توان مصرفی حدود 700 وات دارند. بر اساس محاسبات انجام شده، آموزش این مدل به انتشار حدود 2040 تن دیاکسید کربن معادل در محل منجر شدهاست. با این حال، از آنجایی که شرکت متا از انرژیهای تجدیدپذیر استفاده میکند، انتشار کلی گازهای گلخانهای مربوط به این فرآیند صفر بودهاست.

| مشخصه | مقدار | واحد | توضیحات |

| زمان آموزش | 7 میلیون | ساعت GPU | مدت زمانی که پردازندههای گرافیکی برای آموزش مدل کار کردهاند. |

| توان مصرفی | 700 | وات | میزان توان مصرفی هر پردازنده گرافیکی در طول آموزش |

| انتشار گازهای گلخانهای مبتنی بر مکان | 2040 | تن CO2eq | میزان انتشار گازهای گلخانهای در محل آموزش مدل |

| انتشار گازهای گلخانهای مبتنی بر بازار | 0 | تن CO2eq | میزان انتشار گازهای گلخانهای در نظر گرفته شده با در نظر گرفتن انرژیهای تجدیدپذیر |

در مجموع، آموزش مدلهای زبانی بزرگ میتواند تأثیر قابل توجهی بر محیط زیست داشته باشد. اما متا با انتشار جزئیات مربوط به مصرف انرژی و استفاده از انرژیهای تجدیدپذیر، گامی مهم در جهت کاهش این تأثیر برداشتهاست. علاوه بر این، با انتشار آزاد مدل Llama 3.3، متا امکان استفاده مجدد از این مدل را برای سایر توسعهدهندگان فراهم کردهاست که میتواند به کاهش مصرف انرژی در کل جامعه هوش مصنوعی کمک کند.

موارد استفاده، مشارکت جامعه و ملاحظات اخلاقی در مدل Llama 3.3

مدل زبانی بزرگ Llama 3.3 صرفاً یک دستاورد فنی محسوب نمیشود بلکه یک دارایی ارزشمند برای حوزههای تحقیقاتی و تجاری نیز به شمار میرود. این مدل برای طیف گستردهای از کاربردها از جمله طراحی چتباتها، انجام وظایف چندزبانه، تولید کد و بسیاری موارد دیگر قابل استفادهاست. مجوز انجمن مدل Llama 3.3 به توسعهدهندگان اجازه میدهد تا از این مدل برای کاربردهای متنوعی همچون تولید دادههای مصنوعی و سادهسازی مدلها استفاده کنند. البته، رعایت دستورالعملها و سیاستهای استفاده از این مدل ضروری است. اگرچه مدل اولیه بر چندین زبان اصلی تمرکز دارد، توسعهدهندگان میتوانند با انجام تنظیمات دقیق، آن را برای زبانهای دیگر نیز تطبیق دهند. با این حال، مسئولیت استفاده ایمن و قانونی از این مدل بر عهده خود توسعهدهندگان خواهد بود.

برای استفاده مؤثر از مدل Llama 3.3، تنها تکیه بر مدل کافی نیست. این مدل به عنوان یک جزء اصلی عمل کرده و برای استقرار در محصولات و خدمات، نیازمند اقدامات امنیتی و حفاظتی سطح سیستم است. به عبارت دیگر، مدل Llama 3.3 باید به عنوان بخشی از یک سیستم جامع در نظر گرفته شود که از حریم خصوصی کاربران محافظت کرده، امنیت دادهها را تضمین کرده و خطرات احتمالی را کاهش دهد. برای مثال، در صورتی که قصد دارید از این مدل برای ایجاد ابزارهایی که با سرویسهای خارجی تعامل دارند استفاده کنید (مانند فراخوانی API های خارجی یا مدیریت تولید کد)، باید سیاستهای امنیتی دقیق را تعریف کرده و سرویسهای شخص ثالث را به دقت ارزیابی کنید.

جامعه نقش بسیار مهمی در توسعه و بهبود Llama 3.3 ایفا میکند. شرکت متا از طریق مکانیزمهای بازخورد، به توسعهدهندگان این امکان را میدهد تا نظرات، پیشنهادات و گزارش باگهای خود را ارائه دهند. این رویکرد تعاملی به بهبود مستمر مدل و اکوسیستم آن کمک میکند. علاوه بر این، متا با همکاری کنسرسیومها و سازمانهای ارزیابی، در جهت استانداردسازی روشهای ارزیابی ایمنی و محتوای مدلهای زبانی تلاش میکند. ابزارهایی مانند Purple Llama، Llama Guard 3 و Prompt Guard نیز برای کمک به توسعهدهندگان در ایجاد سیستمهای امنتر ارائه شدهاند.

متا از طریق برنامههای حمایتی مختلف، از جامعه توسعهدهندگان حمایت میکند و به شناسایی و توسعه کاربردهای مدل Llama در حوزههایی مانند آموزش، محیط زیست و نوآوریهای باز میپردازد. این برنامهها نشاندهنده تعهد متا به ایجاد تأثیر مثبت اجتماعی با استفاده از فناوری هوش مصنوعی است.

ملاحظات اخلاقی در توسعه و استفاده از مدل Llama 3.3 از اهمیت بالایی برخوردار است. این مدل بر اساس ارزشهای مقاومت در برابر سانسور و محدودیت، فراگیری و مفید بودن طراحی شدهاست و به آزادی بیان احترام میگذارد. با این حال، همانند هر مدل زبانی دیگر، احتمال تولید محتوای نادرست، مغرضانه و دارای سوگیری یا توهینآمیز توسط مدل Llama 3.3 وجود دارد. بنابراین، توسعهدهندگان باید قبل از استقرار مدل، آزمایشهای ایمنی دقیقی را انجام دهند تا اطمینان حاصل کنند که مدل با استانداردهای اخلاقی آنها همسو است.

توسعهدهندگان مدل Llama 3.3 به طور ویژه بر روی برخی از چالشهای مهم تمرکز کردهاند. از جمله این چالشها میتوان به خطرات ناشی از استفاده سوء از مدل در حوزههایی مانند ایمنی کودکان، حملات سایبری و تولید مواد خطرناک CBRNE (مواد شیمیایی، بیولوژیکی، رادیواکتیویتی، هسته ای و انفجاری) اشاره کرد. برای کاهش این خطرات، کارشناسان حوزههای مختلف، تمرینات ارزیابی نفوذ را بر روی مدل انجام دادهاند. همچنین، جنبههای چندزبانه مدل به دقت بررسی شده تا اطمینان حاصل شود که عملکرد و ایمنی مدل در تمام زبانهای پشتیبانیشده حفظ میشود. توسعهدهندگان به صراحت هشدار داده شدهاند که از مدل برای زبانهایی که در لیست زبانهای پشتیبانیشده قرار ندارند، بدون انجام تنظیم دقیق و همترازی مناسب استفاده نکنند.

مدل Llama 3.3 نقش مهمی در استانداردسازی روشهای ارزیابی ایمنی مدلهای زبانی ایفا میکند. شرکت متا با همکاری با سایر سازمانها، به دنبال ایجاد استانداردهای مشترک برای ارزیابی ایمنی مدلها است. انتشار گزارشهای شفافیت عمومی که جزئیاتی در مورد فرایند توسعه مدل، مصرف انرژی و اقدامات ایمنی ارائه میدهد، به افزایش اعتماد و اطمینان به این مدل کمک میکند.

برای ارزیابی نقاط ضعف و آسیبپذیریهای مدل Llama 3.3، آزمایشهای متعدد و دقیقی بر روی آن انجام شده است. در این آزمایشها، مدل در معرض انواع مختلف حملات و درخواستهای مخرب قرار گرفتهاست. نتایج این آزمایشها به بهبود مستمر مکانیزمهای ایمنی مدل منجر شدهاست. این رویکرد نشان میدهد که توسعه یک مدل زبانی بزرگ، یک فرآیند پویا و مستمر است که نیازمند بازخورد و بهبود مداوم است.

مدلهای زبانی بزرگ مانند Llama 3.3 نباید به صورت مجزا و ایزوله مورد استفاده قرار گیرند. این مدلها باید به عنوان بخشی از یک سیستم جامع در نظر گرفته شوند که مکانیزمهایی برای مدیریت احراز هویت کاربران، حفاظت از دادههای حساس و رعایت مقررات قانونی داشته باشد. به عبارت دیگر، مسئولیت عملکرد ایمن یک مدل زبانی تنها به خود مدل محدود نمیشود، بلکه به کل سیستم و زیرساختهایی که این مدل در آن قرار دارد، مربوط میشود.

نتیجه گیری

مدل زبانی بزرگ Llama 3.3، یکی از تحولات نوین در عرصه هوش مصنوعی محسوب میشود. این مدل با تلفیق کارایی، عملکرد بالا و دسترسی آسان، استانداردهای جدیدی را در این حوزه تعریف کردهاست. در حالی که بسیاری از مدلهای زبانی بزرگ قبلی نیازمند زیرساختهای محاسباتی بسیار قدرتمندی بودند، مدل Llama 3.3 میتواند بر روی سیستمهای معمولی اجرا شود. این مدل بدون آنکه از نظر عملکرد نسبت به مدلهای پیشین مانند Llama 3.1 405B عقب بماند، هزینههای محاسباتی را به طور قابل توجهی کاهش دادهاست.

اما تواناییهای مدل Llama 3.3 فراتر از قدرت محاسباتی است. با بهرهگیری از تکنیکهای پیشرفته یادگیری تقویتی و ادغام بازخورد انسانی، این مدل به استانداردهای بالایی در زمینه ایمنی و اخلاق دست یافتهاست. مدل زبانی بزرگ Llama 3.3 به اهمیت همسو بودن فناوری با نیازهای انسانی و ارزشهای اجتماعی واقف بوده و در این راستا، اطلاعات شفافی در مورد تأثیرات زیستمحیطی خود ارائه میدهد و از مشارکت فعال جامعه استقبال میکند.

مدل Llama 3.3 طیف گستردهای از کاربردهای دنیای واقعی را پوشش میدهد. از ترجمه زبانهای مختلف و تولید کد گرفته تا تولید دادههای مصنوعی و استدلالهای پیچیده، این مدل عملکرد بسیار خوبی از خود نشان میدهد. با این حال، توسعهدهندگان باید به این نکته توجه داشته باشند که استفاده مسئولانه و ایمن از این مدل، مستلزم آزمایشها و تنظیمات دقیق است. جامعهای از هوش مصنوعی که حول این مدل شکل گرفتهاست، با اشتراکگذاری بازخورد و بهترین شیوهها، به بهبود مستمر آن کمک میکند.

Llama 3.3 نشان میدهد که میتوانیم به آیندهای روشنتر در حوزه هوش مصنوعی امیدوار باشیم. این مدل با کاهش موانع ورود، افزایش شفافیت و توجه به مسائل اخلاقی، مسیری جدید را برای توسعه مدلهای زبانی بزرگ هموار کرده است. توسعهدهندگانی که از مدل Llama 3.3 استفاده میکنند، در واقع به ساخت آیندهای پایدارتر و اخلاقیتر در حوزه هوش مصنوعی کمک میکنند.

- ساعت GPU به کل مدت زمانی اشاره دارد که یک GPU (واحد پردازش گرافیکی) برای پردازش وظایف استفاده میشود. این معیار اغلب در محاسبات ابری و محیطهای محاسباتی با عملکرد بالا برای اندازهگیری میزان استفاده و هزینه مرتبط با منابع GPU استفاده میشود. ↩︎

اگر محتوای ما برایتان جذاب بود و چیزی از آن آموختید، لطفاً لحظهای وقت بگذارید و این چند خط را بخوانید:

ما گروهی کوچک و مستقل از دوستداران علم و فناوری هستیم که تنها با حمایتهای شما میتوانیم به راه خود ادامه دهیم. اگر محتوای ما را مفید یافتید و مایلید از ما حمایت کنید، سادهترین و مستقیمترین راه، کمک مالی از طریق لینک دونیت در پایین صفحه است.

اما اگر به هر دلیلی امکان حمایت مالی ندارید، همراهی شما به شکلهای دیگر هم برای ما ارزشمند است. با معرفی ما به دوستانتان، لایک، کامنت یا هر نوع تعامل دیگر، میتوانید در این مسیر کنار ما باشید و یاریمان کنید. ❤️